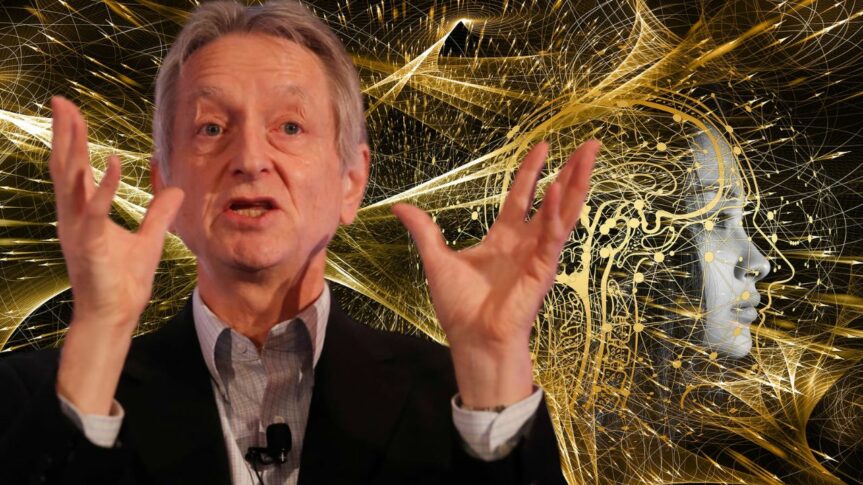

Geoffrey Hinton est un pionnier de l’intelligence artificielle. En 2012, le Dr Hinton et deux de ses étudiants diplômés de l’Université de Toronto ont créé une technologie qui est devenue le fondement intellectuel des systèmes d’intelligence artificielle (IA) que les plus grandes entreprises du secteur technologique considèrent comme la clé de leur avenir. Le 1er mai 2023, il a cependant officiellement rejoint un chœur croissant de critiques qui affirment que ces entreprises courent vers le danger avec leur campagne agressive visant à créer des produits basés sur l’intelligence artificielle générative, la technologie qui alimente les chatbots populaires comme ChatGPT.

Le Dr Hinton a déclaré qu’il avait quitté son emploi chez Google, où il a travaillé pendant plus de dix ans et est devenu l’une des voix les plus respectées du domaine, afin de pouvoir s’exprimer librement sur les risques de l’IA. Une partie de lui, a-t-il dit, regrette désormais le travail de toute une vie. « Je me console avec l’excuse habituelle : si je ne l’avais pas fait, quelqu’un d’autre l’aurait fait », a déclaré le Dr Hinton lors d’une longue entrevue dans la salle à manger de sa maison à Toronto, à quelques pas de l’endroit où lui et ses étudiants ont fait leur percée.

Le parcours du Dr Hinton, de pionnier de l’IA à prophète de malheur, marque un tournant important pour l’industrie technologique, qui en est peut-être à son point d’inflexion le plus important depuis des décennies. Les leaders de l’industrie estiment que les nouveaux systèmes d’IA pourraient être aussi importants que l’introduction du navigateur Web au début des années 1990 et pourraient conduire à des avancées dans des domaines allant de la recherche pharmaceutique à l’éducation.

Mais de nombreux acteurs du secteur craignent de diffuser quelque chose de dangereux dans la nature. L’IA générative peut déjà être un outil de désinformation. Bientôt, elle pourrait représenter un risque pour l’emploi. À terme, selon les plus grands inquiets de la technologie, elle pourrait représenter un risque pour l’humanité. « Il est difficile de voir comment on peut empêcher les mauvais acteurs de l’utiliser à de mauvaises fins », a déclaré le Dr Hinton.

Après que la start-up de San Francisco OpenAI a publié une nouvelle version de ChatGPT en mars 2023, plus de 1 000 leaders et chercheurs en technologie ont signé une lettre ouverte appelant à un moratoire de six mois sur le développement de nouveaux systèmes, car les technologies d’IA présentent « de profonds risques pour la société et l’humanité ». Quelques jours plus tard, 19 dirigeants actuels et anciens de l’Association pour l’avancement de l’intelligence artificielle, une société universitaire vieille de 40 ans, ont publié leur propre lettre d’avertissement sur les risques de l’IA. Ce groupe comprenait Eric Horvitz, directeur scientifique de Microsoft, qui a déployé la technologie d’OpenAI sur une large gamme de produits, y compris son moteur de recherche Bing.

Le Dr Hinton, souvent surnommé « le parrain de l’intelligence artificielle », n’a signé aucune de ces lettres et a déclaré qu’il ne souhaitait pas critiquer publiquement Google ou d’autres entreprises avant d’avoir quitté son emploi. Il a informé l’entreprise de sa démission et le 27 avril 2023, il s’est entretenu au téléphone avec Sundar Pichai, le directeur général de la société mère de Google, Alphabet. Il a refusé de discuter publiquement des détails de sa conversation avec M. Pichai. Jeff Dean, scientifique en chef de Google, a déclaré dans un communiqué : « Nous restons engagés dans une approche responsable de l’IA. Nous apprenons continuellement à comprendre les risques émergents tout en innovant avec audace. »

Le Dr Hinton, un expatrié britannique de 75 ans, est un universitaire de longue date dont la carrière a été guidée par ses convictions personnelles sur le développement et l’utilisation de l’IA. En 1972, alors qu’il était étudiant diplômé à l’Université d’Édimbourg, le Dr Hinton a adopté une idée appelée réseau neuronal. Un réseau neuronal est un système mathématique qui apprend des compétences en analysant des données. À l’époque, peu de chercheurs croyaient en cette idée. Mais c’est devenu l’œuvre de sa vie.

Dans les années 1980, le Dr Hinton était professeur d’informatique à l’université Carnegie Mellon, mais il a quitté l’université pour le Canada parce qu’il était réticent à accepter des financements du Pentagone. À l’époque, la plupart des recherches sur l’intelligence artificielle aux États-Unis étaient financées par le ministère de la Défense. Le Dr Hinton est profondément opposé à l’utilisation de l’intelligence artificielle sur le champ de bataille – ce qu’il appelle des « soldats robots ».

En 2012, le Dr Hinton et deux de ses étudiants de Toronto, Ilya Sutskever et Alex Krishevsky, ont construit un réseau neuronal capable d’analyser des milliers de photos et d’apprendre à identifier des objets courants, tels que des fleurs, des chiens et des voitures. Google a dépensé 44 millions de dollars pour acquérir une entreprise fondée par le Dr Hinton et ses deux étudiants. Leur système a donné naissance à des technologies de plus en plus puissantes, notamment de nouveaux chatbots comme ChatGPT et Google Bard. M. Sutskever est ensuite devenu scientifique en chef chez OpenAI. En 2018, le Dr Hinton et deux autres collaborateurs de longue date ont reçu le prix Turing, souvent appelé « le prix Nobel de l’informatique », pour leurs travaux sur les réseaux neuronaux.

➤ Ilya Sutskever, scientifique en chef d’OpenAi, a travaillé avec le Dr Hinton sur ses recherches à Toronto. Crédit : Jim Wilson/The New York Times.

À la même époque, Google, OpenAI et d’autres entreprises ont commencé à créer des réseaux neuronaux capables d’apprendre à partir d’énormes quantités de textes numériques. Le Dr Hinton pensait que c’était un moyen puissant pour les machines de comprendre et de générer du langage, mais que c’était inférieur à la façon dont les humains géraient le langage. En 2022, alors que Google et OpenAI ont développé des systèmes utilisant des volumes de données bien plus importants, son point de vue a changé. Il pensait toujours que ces systèmes étaient inférieurs au cerveau humain sur certains points, mais qu’ils éclipsaient l’intelligence humaine sur d’autres. « Peut-être que ce qui se passe dans ces systèmes est bien meilleur que ce qui se passe dans le cerveau », a-t-il déclaré.

Lisez la suite de cet article à partir de 2,00 $CA seulement !

Abonnez-vous à ma lettre d’information

Et recevez un code de réduction de 40 % pour l’adhésion à mon Club VIP.

En tant qu’auteur et chroniqueur indépendant, Guy Boulianne est membre du réseau d’auteurs et d’éditeurs AuthorsDen et de la Nonfiction Authors Association (NFAA) aux États-Unis. Il adhère à la Charte d’éthique mondiale des journalistes de la Fédération internationale des journalistes (FJI).

[…] artificielle, nous mettait en garde contre cette technologie avant son départ de Google en 2023. Selon lui, à mesure que les entreprises améliorent leurs systèmes d’IA, ces derniers deviennent de plus […]

[…] très stupide. Je veux dire, avec l’intelligence artificielle, nous invoquons le démon. » [Lire cet article] Toutes ces images et vidéos générées par l’IA brouillent l’esprit et insufflent un […]

🚀 Elon Musk vient de déclarer que c’est la meilleure vidéo sur l’IA de tous les temps ! 🤖🔥 Êtes-vous d’accord ? Faites-nous part de vos impressions ! 👇

Google DeepMind a développé un robot alimenté par l’IA prêt à jouer au tennis de table. 🤖🏓

Il s’agit du premier agent à atteindre une performance de niveau amateur humain dans ce sport.

🚨 La femme dans cette vidéo n’est pas réelle, elle est générée par l’IA ! La vidéo (à gauche) a été créée avec Runway Gen 3, et l’image (à droite) avec Flux. Avec des outils comme ceux-ci, il devient de plus en plus difficile de distinguer le vrai du faux. Restez vigilants ! 🤖👀 #AI #Deepfake #Chat GPT

Faites place à Alexa et Siri ! Les meilleurs amis robots sont là ! 🤖✨

MenteeBot en Israël forme des robots à pousser des chariots pour les utilisateurs de fauteuils roulants. 🛒

De plus, le nouveau MenteeBot V3 apporte des mises à jour majeures au niveau matériel et logiciel.

Qui a besoin de compagnons humains avec un acolyte robotique ? 🤖

L’IA insuffle une nouvelle vie aux portraits historiques. 😲😲✨

Imaginez si ces personnages célèbres pouvaient parler : que leur demanderiez-vous ? Partagez vos questions les plus intrigantes et explorons ensemble l’art du dialogue ! 🖼️🤖

J’ai visionné une démo d’AI News Presenter sur Reddit en utilisant Flux Dev pour la création de personnages, RunwayML pour l’animation et Synthesia IO pour la voix. L’intégration est transparente, mettant en évidence le rôle croissant de l’IA dans les médias.

Robot + IA + dextérité étonnante = Figure 02.

Figure 02 est un robot humanoïde hautement adroit, alimenté par l’IA, conçu pour la polyvalence et les applications du monde réel.

Le développement de l’intelligence artificielle et de l’idéologie politique peut être très dangereux pour les crédules. Il suffit de regarder jusqu’où les Deepfakes sont allés et à quel point il est facile de créer une nouvelle « vérité ». Heureusement pour les êtres intuitifs, ces autres sont faciles à tromper.